探索之路:人工智能发展的回顾与展望

2024年10月25日 来源:互联网 OEM代加工网

演讲人:张钹 演讲地点:清华大学“人文清华讲坛” 演讲时间:2024年4月

张钹 中国科学院院士,清华大学计算机系教授,清华大学人工智能研究院名誉院长。2011年德国汉堡大学授予自然科学名誉博士,获2014年度CCF(中国计算机学会)终身成就奖,2019年度吴文俊人工智能科学技术奖最高成就奖。主要从事人工智能、人工神经网络和机器学习等理论研究,以及模式识别、知识工程和机器人等应用技术研究。在上述领域发表学术论文200多篇、专著5部(章)。科研成果获ICL欧洲人工智能奖等奖项。

人工智能的两条路径

迄今为止,全世界对于“什么是智能”尚无统一认识,但经过多年的探索,人工智能已然走出了两条道路。一条道路是行为主义学派,另一条道路是内在主义学派。

其中,行为主义学派主张用机器模拟人类的智能行为。“智能”与“智能的行为”是两个完全不同的概念。“智能”在我们大脑里,人类至今仍对其知之甚少;“智能的行为”则是智能的外部表现,可以进行观察和模拟。因此,行为主义学派人工智能追求的目标是机器行为与人类行为的相似性,而非内部工作原理的一致性。目前人工智能的主流是机器智能,这种人工智能与人类的智能只存在行为相似,并非完全一致。内在主义学派主张必须用机器模拟人类大脑的工作原理,即类脑计算。这两个学派按照不同的思路对人工智能进行探索,前者主张除人类这条道路外,机器或其他方法也可以走出一条智能道路;后者主张走向智能道路只能依靠人类。目前这两种思路都处于探索阶段。

人类对人工智能道路的探索始于1956年。当时在美国召开了人工智能研讨会,来自数学、计算机科学、认知心理学、经济学和哲学等不同领域的10位专家经过八周的讨论定义了人工智能。他们主张通过符号推理、符号表示来做一个能像人那样思考的机器。在这次会议上,纽维尔(Newell)和西蒙(Simon)演示了一个名为“逻辑学家”的程序。该程序用机器证明了数学原理第二章中的部分原理,数学定理证明与推理相似,这表明机器能做类似推理的工作。最终,“人工智能”在这个会议上获得了定义。

1978年,清华大学成立了人工智能与智能控制教研组,这是中国最早的人工智能教学与科研机构。教研组有三十余位教师参与,其中绝大部分来自自动控制领域,而非人工智能。1978年,教研组招收了第一批硕士生,1985年开始招收第一批博士生,已能够开展一些与人工智能相关的教学工作,但科研工作进展不大。1982年至1984年,教研组进行调查研究,访问了西南、东北等地大量研究所及工厂。结合所见所闻,教研组确定了以智能机器人作为主要研究方向。

1985年清华大学建立智能机器人实验室,1986年国家设立“863”发展计划,该计划将智能机器人作为一个主题。清华大学参加了第一届智能机器人主题的“863”高技术研究,从第一届到第四届均作为专家单位参加委员会。到了第五届,清华大学成为开展智能机器人研究的组长单位,1997年,成为空间机器人研究的组长单位。“智能技术与系统”国家重点实验室自1987年开始筹建,1990年正式成立。在这些工作的基础上,相关研究得以开展。当时首先建立了两个理论。一是问题求解的商空间理论和粒计算理论,在国际上影响很大。2005年,清华大学发起、组织了国际粒计算会议,每年一次,延续至今。二是在人工神经网络方面做了很多早期工作。

在杭州举办的2023云栖大会上,观众在“人工智能+”展馆参观人工智能产品及应用。新华社发

人工智能的三个阶段

1956年至今,人工智能的发展分为三个阶段,分别是第一代人工智能、第二代人工智能和第三代人工智能。

第一代人工智能的目标是让机器像人类一样思考。思考是指推理、决策、诊断、设计、规划、创作、学习等。无论做管理工作还是技术工作,都需要两方面的能力,一是在某个领域具有丰富的知识和经验,二是具有很强的推理能力。其中推理是指运用知识的能力,换言之,是从已有知识出发,推出新的结论、新的知识的能力。基于以上分析,人工智能的创始人提出了“基于知识与经验的推理模型”,该模型的核心是若要实现机器思考,只需将相应的知识放入计算机即可。例如,如果要让计算机像医生一样为患者诊断,只需要把医生的知识和经验放到知识库里,将医生看病的推理过程放入推理机制之中,计算机就能为患者实施机器诊断。这一推理模型的核心思想是知识驱动,通过计算模型来实现让机器像人类那样思考。该模型最大的缺点是缺乏自学能力,难以从客观世界学习知识,所有知识都源于人类灌输。因此,第一代人工智能永远无法超越人类。

第二代人工智能源于第一代人工智能的低潮期,主要基于人工神经网络。1943年,人工神经网络模型提出,它主要模拟人类脑神经网络的工作原理。第二代人工智能面临的主要问题是感性知识的传授。第一代人工智能主要在符号主义指导下进行,目的是模拟人类的理性行为。但人类除了理性行为外,还有大量的感性行为,而感性行为要用人工神经网络进行模拟。我们常说知识是人类智慧的源泉,知识是理性行为的基础,这里的知识来自教育,主要指理性知识、分析问题的方法等。但感性的知识难以用语言传授,也无法从书本上获得。每一个人最初得到的感性知识是对自己母亲的认识。但,具体是什么时候开始对母亲有所认识的?又是怎样实现这种认识的?这些问题到现在仍难以解答。所有感性知识都在不断观察、不断倾听的过程中学习累积,第二代人工智能深度学习沿用了这个方法。例如,过去我们主要通过编程的方法告诉计算机马、牛、羊的具体特征,现在则将网上大量马、牛、羊的照片做成训练样本,让计算机进行观察和学习即可。学习完毕,再把剩下的样本作为测试样本去测试它,识别率能达到95%以上。观察和倾听的过程通过人工神经网络进行,将识别的问题作为分类问题,利用人工神经网络来分类。通过神经网络进行学习的过程称为深度学习,基于深度学习能够进行分类、预测和生成等。但是第二代人工智能的所有数据(图像、语音等)均来自客观世界,它的识别只能用于区别不同的物体,并不能真正地认识物体。所以第二代人工智能最大的问题是不安全、不可信、不可控、不可靠、不易推广。

第三代人工智能的基本思路是必须发展人工智能理论。迄今为止,人工智能尚无较为成型的理论,更多是模型和算法,且第一代和第二代人工智能的模型、算法都有很多缺陷。因此,必须大力发展科学完备的人工智能理论,在此基础上,才能发展出安全、可控、可信、可靠和可扩展的人工智能技术。对目前的人工智能技术而言,虽然提高了效率和质量,但系统越信息化和智能化,也就意味着越不安全。第一代人工智能运用了知识、算法、算力三个要素,其中最主要的是知识。第二代人工智能则主要用了数据、算法和算力三个要素。为了克服人工智能的固有缺点,唯一的办法是把知识、数据、算法和算力这四个要素同时运用。目前得到较多运用的AI工具(大语言模型),就能够充分利用知识、数据、算法、算力这四个要素。清华大学团队提出了第三代人工智能的三空间模型,将整个感知、认知系统进行连接,为发展人工智能理论提供了非常好的条件。

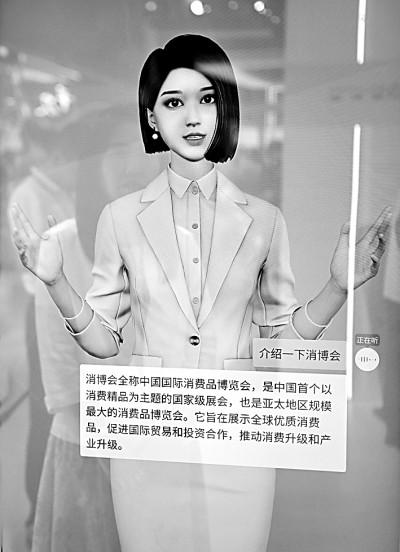

第四届消博会上,一款“AI数字人”在回答观众提问。新华社发

深度学习的不安全性

在研究过程中,研究者发现了人工智能深度学习的不安全性。

其中一个典型案例是:研究者制作了雪山和狗的对比图,先让计算机和人看雪山,二者都能判定为雪山,但是只要在图片上添加一点噪声,人看雪山仍是雪山,计算机却会将雪山看成一条狗。这个案例说明,人工智能目前基于深度学习的模式识别跟人类的视觉完全不同,尽管它能够像人类那样区分雪山和狗,但实际上它既不认识狗,也不认识雪山。这里面的关键问题是——什么是狗?应该如何定义一条狗?人类通常通过视觉来进行区分,主要看狗的外形,但什么是狗的外形?狗有各种形态、各种姿势,为什么人类的视觉能够在千变万化的外形里确定目标是狗?这个问题的答案,到现在为止尚未弄清楚。最早的计算机识别狗时,狗变换了位置后计算机就不能识别了,这是位移的不变性,这个问题现在已经解决。但是尚未解决的问题还有很多。例如,计算机能够识别固定尺寸的狗,但是把狗变大或变小后都难以识别,这是大小的不变性。现在计算机只能通过局部纹理来区分狗和雪山。因此,如果将雪山图上的某个纹理改成皮毛纹理,即便雪山的形状保持不变,计算机仍会把雪山误认为是狗。所以说,到目前为止,人工智能的深度学习仍然不够安全可靠。

中国科学院自动化研究所人形机器人攻关团队科研人员在多模态人工智能系统全国重点实验室调试机器人。新华社发

大语言模型的“大模型”与“大文本”

目前比较成功的AI工具,其强大性主要来源于两个“大”,一是大模型,二是大文本。

第一个大模型的“大”是大的人工神经网络,人工神经网络可以用来分类、学习数据中间的关联关系,也可以用来预测。这个巨大的人工神经网络叫“转换器”。AI工具的能力强大,离不开深度神经网络的强大。原来的神经网络是逐字输入,现在一次能够输入2000多字(一个token,粗略地讲相当于一个汉字)。人类从1957年到2013年花了56年时间探究文本的语意表示问题,现在的文本不是用符号表示,而是用语意向量表示,这也是最重要的一个突破。过去计算机处理文本只能把它当作数据处理,现在可以把它当成知识来处理,即向量表示。此外,还提出了“自监督学习”。过去供计算机学习的文本都要做预处理、预先标注,此项工作量太大,所以无法支撑计算机大量学习。自监督学习是指原来的文本不经过任何处理就可以被计算机学习,用前面的文本预测后面的词,输入后预测下一个,被预测的内容又把再下一个变成输入,有些类似于接龙式学习方式。

第二个“大”是大文本。计算机实现自监督学习后,所有文本不用经过任何预处理就可以学习,文本也由原来的GB量级发展为TB量级。现在比较成功的人工智能大约学习了40TB以上,相当于一千多万本牛津辞典,并且这个学习过程并非死读,而是理解其中的内容。这就使得我们进入了生成式人工智能时代。无论是第一代还是第二代人工智能,都受到三个限制——特定领域用特定模型完成特定任务。“三个特定”是所谓的“窄人工智能”,即专用人工智能。目前比较成功的AI工具能够通过其强大的语言生成能力让人类在与它对话时没有领域限制,这是人工智能的重大进步。另外,生成多样性的输出是目前AI工具的重要特征。它有多样化的输出就有可能创新,因为输出多样化,难以保证每个输出都正确,所以越希望它能输出有创造性,就越要允许它犯错误。我们在日常使用一些AI工具时也会发现,有时AI对问题的回答非常机智聪明,有时则是明显的胡说八道,这就是多样化输出的结果。

目前AI工具产生了两个重大突破,一是生成语意连贯的类似人类的文本,二是在开领域实现了人机自然语言对话。大语言模型是向通用人工智能迈出的一步,有西方专家认为这是通用人工智能的曙光,但它并不是通用人工智能,人类走向通用人工智能依然任重道远。

走向通用人工智能必须满足三个条件。第一,系统必须与领域无关。目前较为成功的AI工具在对话、自然语言处理的问题上做到了与领域无关,但在处理其他大量问题上仍难以实现这一目标。第二,系统与任务无关,即什么任务都会做。目前AI工具能进行对话、四则运算、作诗、写代码等多种任务,但仍难以完成复杂环境下的复杂任务。第三,尚需建立一个统一的理论。因此,人工智能还有很长的路要走。

大语言模型迈向通用人工智能的四个步骤

从大语言模型迈向通用人工智能需要四个步骤。第一步是跟人类进行交互、与人类对齐,第二步是多模态生成,第三步是与数字世界交互,第四步是与客观世界交互。我们并不是说,完成这四步就意味着实现了通用人工智能,而是说通往通用人工智能这个目标,至少需要迈出以上四步。

第一步是与人类对齐。目前AI工具输出的内容不一定正确,若要解决这个问题,必须依靠人类帮助它克服,使之与人类对齐。从AI工具的应用实践来看,它的错误需要人类帮助纠正,而且它的错误纠正速度和迭代速度都很快。与此同时,我们要看到输出内容的错误仍然存在,但我们如果想要它具有创造性,就要允许它犯错误。

第二步是多模态生成。现在已经可以用大模型生成图像、声音、视频、代码等各种模态的内容。随着技术的进步,鉴别一个内容是由机器生成还是人工完成将会变得越来越困难,这为“造假”提供了非常好的机会。“造假”又名“深度造假”,即用深度学习的办法“造假”。试想一下,如果以后网络上95%的文本都由AI生成,那么我们还能通过网络获取真知与真相吗?比方说,当一件事情发生后,网络上出现一片支持或者反对意见,这些意见究竟是来自多数人的真实表达,还是来自少数人操纵AI歪曲事实?如何有效防止AI工具操纵舆论、混淆视听,这是需要我们严肃考虑的。

目前人工智能领域已经实现了三项突破,即开领域生成语意连贯的类似人类的文本。其中,语意连贯是最重要的突破,这个突破后就有了图像的突破。因为图像只要求在空间上连贯即可,而视频则进一步要求时空上的连贯。我们在语言上进行突破,紧接着会有图像的突破,图像突破后肯定还会有视频的突破。在这个发展过程中,计算的资源要求和硬件都会变得越来越多。

随着人工智能的发展,很多人注意到了“涌现”现象。例如,当系统规模没有达到一定程度时,生成的图画很糟糕、水平较差,但当规模达到一定程度,生成的大多数图画突然间就变得质量很高。这个过程称为“涌现”,“涌现”是从量变到质变的过程。到目前为止,全世界范围内都还无法完全理解“涌现”现象出现的原因。

第三步是AI智能体。大语言模型迈向通用人工智能必须与数字世界进行连接,首先在数字世界里具体操作,从而解决问题、感知自己成果的优劣,并进行反馈。这个工作对促进大模型的性能向前发展有很大益处。

第四步是具身智能。具身智能,即具有身体的智能。智能光有脑还不够,还必须具有身体,这样才能动口又动手。所以,大语言模型迈向通用人工智能,必须通过机器人与客观世界连在一起。

第六届世界声博会上,小朋友们在参观体验一款弈棋机器人(2023年摄)。新华社发

人工智能的产业发展

当下,信息产业的发展非常迅猛,原因在于建立了相关理论,在理论指导下制作的硬件和软件都是通用的。过去,信息产业领域内出现了一些具有世界影响力的大型企业,应用推广相应技术并实现信息化,整个链条发展非常迅速。但是,人工智能产业的发展缺乏理论,只有算法和模型,而根据算法和模型建立的硬件和软件全是专用的。“专用”即意味着市场很小,到现在为止,人工智能产业还没有产生具有世界影响力的大型企业,所以人工智能产业必须跟垂直领域深度结合才有可能发展。不过,目前情况也在发生变化,具有一定通用性的基础模型的出现,肯定会影响产业发展。

2020年,全世界人工智能产业达到10亿美元以上的独角兽企业一共有40家,2022年变成117家,2024年初达到126家,从这个情况来看,它是逐步增长的。到现在为止,中国有100甚至200家企业在做大模型。这么多人做基础模型,他们未来的出路在哪里?

第一个出路是向各行各业转移,做各个垂直领域的大模型。现在很多行业都在考虑这个问题,例如石油行业考虑石油行业的大模型,金融行业考虑金融行业的大模型,所以将来做通用大模型的数量将越来越少,大多数做大模型的人才会转向各个垂直领域。第二个出路是最重要的,即经过微调应用在产业里。换言之,提供公开的大模型软件,让大家开发应用。第三个出路是跟其他技术结合,发展新的产业。国外很多独角兽企业都将AI工具与其他技术结合,发展新产业,有的是向各个行业转移,还有的专门做图像、视频、语音等。国内一些大模型现在也已经取得了比较好的发展。

基于此,势必要推动人工智能领域的产业变革。今后无论做硬件还是做软件,一定要放到基础模型的平台当中。过去是在一个零基础的计算机中制作软件,效率很低,而现在平台已经学习超过一千万本牛津辞典,能力水平至少相当于一个高中生,若将同样的工作放到基础模型的平台上进行将会事半功倍,所以采用这个平台是不可阻挡的趋势。而这些“高中生”则来源于大模型企业提供的公开平台。

大模型的局限性

大模型的所有工作都由外部驱动,在外部提示下进行。它缺乏主动性,在外部提示下做某事时,主要基于概率预测的方法,所以会出现一些人类没有的缺点,即输出的质量不可控。并且它不知道是非对错,所以它的输出也不可信。与此同时,它受外部影响太大,只能听从指令来完成相应的事情。但人类则是完全不同的,即使这件事是由别人安排完成,人也能够在自己的意识控制下进行,所以是可控、可信的。

由此可见,目前的人工智能并不知道自己的所作所为。AI工具尚不能准确分辨对错,且现在还难以主动进行自我迭代,仍旧需要在人类的操作下进行。未来的人工智能最多成为人类的助手,在人类的监控下进行操作,只有少数工作可以完全交给机器独立完成。有研究机构曾做过关于人工智能对各行各业影响的统计,列出了大量行业,在未来这些行业中只有少数工作可能会被人工智能取代。可见,人工智能对各行各业都有重大影响,但大多数是帮助人类提高工作质量和效率,而非取代人类进行工作。

人工智能是探索“无人区”,其魅力就在于它永远在路上。我们不能因为它的进展而过于乐观,也不必因为它的挫折而沮丧,我们需要的是坚持不懈地努力。

(本讲座文稿由清华大学新闻与传播学院博士生牛雪莹整理)

《光明日报》(2024年05月25日 10版)

来源:光明网-《光明日报》

(OEM代加工网:

下一篇:

- 一天

- 三天

- 一周

- 1探索之路:人工智能发展的回顾与展望

- 2【珍康生物】特膳 、蓝帽,一件代发,免费拿样,片剂

- 3枸杞用得好,疾病不来找!枸杞这四种搭配,气血双补身

- 4提速提量!特医产品获批总数达到206个!市场规模持续

- 5人工智能解锁药物研发效率谜题

- 6从中医药百强企业发布,看大健康策划公司排行榜

- 7重磅!华为纯血鸿蒙正式发布,连接设备超10亿台!余承

- 8【原装进口】美国联合制药:全球膳食补充剂

- 9哪些日常食物,可以安全补钙,预防骨质疏松?

- 10牙膏真有这么多功能?

秋季:合理膳食 祛斑更有效

喂宝宝,普及科学知识

保健品行业仍然“朝阳” 行业怪圈

市保健品安全 “正源行动”锁定四